* GPU算力与传统的集群相比对网络的要求更高 , 合理的网络设计才能让HPC的方案性能发挥的更好。

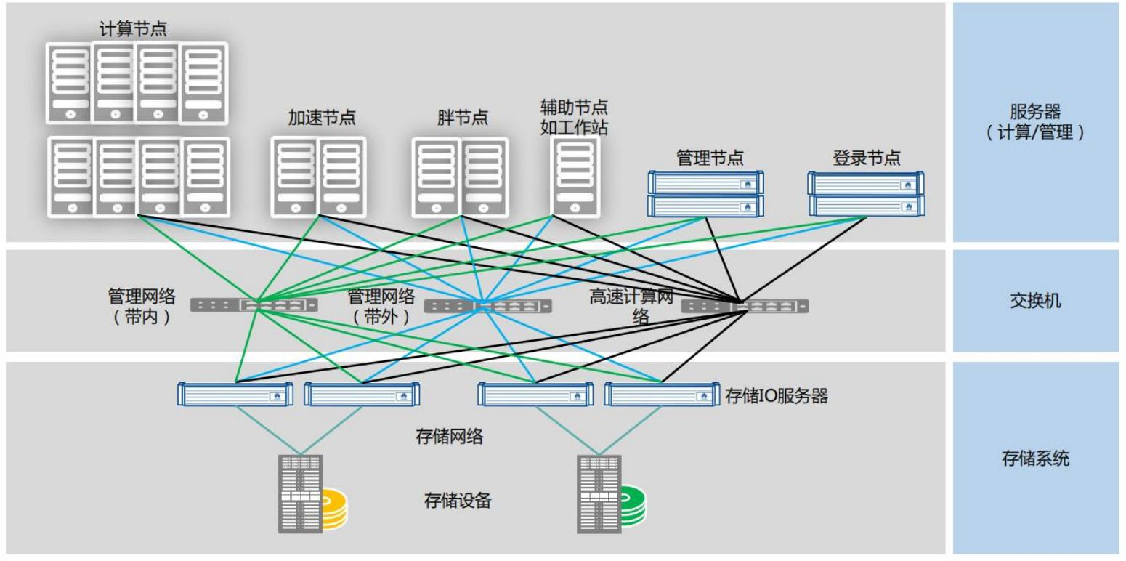

*计算网络:计算网络肩负着GPU算力集群各节点之间高效通信的任务;对于大规模的计算任务,若要大幅度提高计算速度,网络的带宽和延迟都要求很高。

*存储网络:为数据存储提供高速网络IO。

*IB交换机: Infin iband SW , 高带宽、低延时 , GPU算力占据主流。(Mellanox)

*以太网交换机:通常用作管理

*FC交换机 :成熟的存储专用设备 ,低延时 , 最高32Gb ,不占据主流 。

*GPU卡之间通过片上PCIe接口及板载PCIe交换芯片实现多卡互联,服务器间通过以太交换机或IB交换机搭建基于超融合架构的底层硬件平台,从而为上层应用提供计算和存储服务

解决方案

综合服务 解决方案

-

ꁸ 回到顶部

-

ꂅ 010-52713196

-

ꁗ QQ客服

-

ꀥ 微公众号信二维码